vCenter Server で用意されている以下のデフォルトアラームの閾値に

ついて、気になったため vCente Server Appliance に負荷をかけて

みた結果を記載します。

(個人的には特に CPU/メモリが気になったため検証を行いました。)

Memory Exhaustion on <vCSA のホスト名> ★★★

CPU Exhaustion on <vCSA のホスト名> ★★★

Log Disk Exhaustion on <vCSA のホスト名> ★★★

SEAT Disk Exhaustion on <vCSA のホスト名>

Core and Inventory Disk Exhaustion on <vCSA のホスト名>

Root Disk Exhaustion on <vCSA のホスト名>

Boot Disk Exhaustion on <vCSA のホスト名>

Autodeploy Disk Exhaustion on <vCSA のホスト名>

Diagnostics Disk Exhaustion on <vCSA のホスト名>

Image Builder Disk Exhaustion on <vCSA のホスト名>

ESXi Dump Collector Disk Exhaustion on <vCSA のホスト名>

Update Manager Disk Exhaustion on <vCSA のホスト名>

Lifecycle Disk Exhaustion on <vCSA のホスト名>

LVM Snapshot Disk Exhaustion on <vCSA のホスト名>

vStats DB Disk Exhaustion on <vCSA のホスト名>

今回は、上記で ★ を記した <Memory Exhaustion>, <CPU Exhaustion>,

<Log Disk Exhaustion> に絞って検証を行なっていきます。

確認環境

vCenter Server Appliance 7.0 U3

vCenter Server Appliance 8.0 U1

検証方法

今回は検証用に用意した vCSA 上で stress コマンドを使用して

メモリに高負荷をかけてみます。

しかし、vCenter Server ではデフォルトで stress コマンドが

用意されていません。

なので、どのようにして stress コマンドを使用するのかというと、

stress コマンドが使用できる Linux 仮想マシンの /usr/bin 配下

を vCSA にマウントして、vCSA 上でも stress コマンドを使用

しようと思います。

※ 荒業なので、同様の検証をする際は自己責任でお願いします。

root@ss098 [ ~ ]# mkdir /test

root@ss098 [ ~ ]# mount -t nfs -o rw 192.168.0.107:/usr/bin /test -v

mount.nfs: timeout set for Sun Jun 11 16:03:07 2023

mount.nfs: trying text-based options 'vers=4.2,addr=192.168.0.107,clientaddr=192.168.0.98'

root@ss098 [ ~ ]# /test/stress --version

stress 1.0.4CPU に関しては個人的に stress より、yes の方が使い勝手が

良かったので、今回は以下を使用します。

(複数実行し、調整します。)

yes > /dev/null &ディスク使用率に関しては、dd コマンドを使用します。

dd if=/dev/zero of=testfile bs=1M count=1024検証結果

メモリ

<Memory Exhaustion> は 85% で Yellow(警告)、95% で Red(重大)

と言う結果でした。

vCenter Memory Resource status changed from Green to Yellow on ss098.home.com for continuous Memory utilization 85%

vCenter Memory Resource status changed from Green to Red on ss098.home.com for continuous Memory utilization 95%ログからは、[warning threshold=85 critical threshold=95]

となっていることが確認でき、[mem.usage value:] から使用率

が確認できます。

2023-06-18T23:06:30.244Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: mem.usage value: 97.5968 status: green

2023-06-18T23:06:30.244Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] [Unit test] Alarm check cfg warning threshold=85 critical threshold=95 warning alarm raise count=10 critical alarm raise count=10[warning alarm raise count=10 critical alarm raise count=10] に関しては、

StatsMonitor サービスが各リソースの使用率を 1 分間隔でチェックしており、

85% 以上が 10 分間(10 count)、 95% 以上が 10 分間(10 count) 継続した

場合に、それぞれアラームがトリガされると解釈できると思います。

Red(重大) に遷移した場合のログを確認すると以下のようになっており、1 分毎

にカウントが増えていっていることが分かります。

2023-06-18T23:05:29.201Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: mem.usage value: 80.7278 status: green

2023-06-18T23:05:29.201Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] [Unit test] wCount=0 cCount=0

2023-06-18T23:06:30.244Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: mem.usage value: 97.5968 status: green

2023-06-18T23:06:30.244Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] [Unit test] wCount=1 cCount=1

2023-06-18T23:07:37.049Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: mem.usage value: 98.341 status: green

2023-06-18T23:07:37.049Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] [Unit test] wCount=2 cCount=2

2023-06-18T23:08:37.389Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: mem.usage value: 97.6354 status: green

2023-06-18T23:08:37.389Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] [Unit test] wCount=3 cCount=3

2023-06-18T23:09:38.391Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: mem.usage value: 97.8319 status: green

2023-06-18T23:09:38.391Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] [Unit test] wCount=4 cCount=4

2023-06-18T23:10:39.294Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: mem.usage value: 97.9226 status: green

2023-06-18T23:10:39.294Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] [Unit test] wCount=5 cCount=5

2023-06-18T23:11:40.616Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: mem.usage value: 97.9412 status: green

2023-06-18T23:11:40.616Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] [Unit test] wCount=6 cCount=6

2023-06-18T23:12:41.152Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: mem.usage value: 98.1595 status: green

2023-06-18T23:12:41.152Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] [Unit test] wCount=7 cCount=7

2023-06-18T23:13:41.979Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: mem.usage value: 98.1585 status: green

2023-06-18T23:13:41.979Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] [Unit test] wCount=8 cCount=8

2023-06-18T23:14:42.645Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: mem.usage value: 97.9664 status: green

2023-06-18T23:14:42.645Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] [Unit test] wCount=9 cCount=9

2023-06-18T23:15:43.435Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: mem.usage value: 98.0622 status: green

2023-06-18T23:15:43.435Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] [Unit test] Alarm check cfg warning threshold=85 critical threshold=95 warning alarm raise count=10 critical alarm raise count=10

2023-06-18T23:15:43.435Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] Raised WARNING alarm: 10 vs. 10.

2023-06-18T23:15:43.435Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] Raised CRITICAL alarm: 10 vs. 10.

2023-06-18T23:15:43.435Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] [Unit test] wCount=10 cCount=10

2023-06-18T23:15:43.435Z info StatsMonitor[02355] [Originator@6876 sub=StatsMonitor] Post event: mem.usage status changed from green to red.

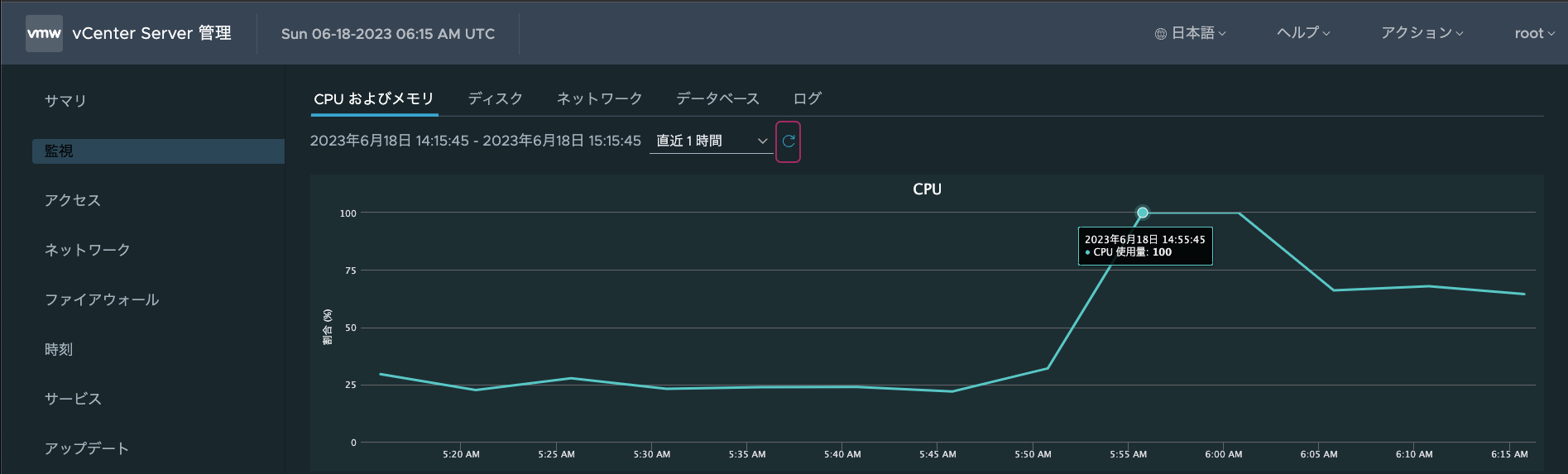

2023-06-18T23:15:43.748Z info StatsMonitor[02360] [Originator@6876 sub=StatsMonitor] eventMessage: [{"event_id": "vim.event.ResourceExhaustionStatusChangedEvent","args":{"resourceName":"mem_usage","oldStatus":"green","newStatus":"red","reason":"for continuous Memory utilization 95% in 0 mins"}}]CPU

<CPU Exhaustion> は 75% で Yellow(警告)、90 % で Red(重大)

と言う結果でした。

vCenter CPU Resource status changed from Green to Yellow on ss098.home.com for continuous CPU utilization 75%

vCenter CPU Resource status changed from Green to Red on ss098.home.com for continuous CPU utilization 90%ログからは、[warning threshold=75 critical threshold=90]

となっていることが確認でき、[cpu.util value:] から使用率が

確認できます。

2023-06-18T05:57:07.758Z info StatsMonitor[39399] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: cpu.util value: 99.9989 status: green

2023-06-18T05:57:07.762Z info StatsMonitor[39399] [Originator@6876 sub=StatsMonitor] [Unit test] Alarm check cfg warning threshold=75 critical threshold=90 warning alarm raise count=5 critical alarm raise count=5[warning alarm raise count=5 critical alarm raise count=5] に関しては、

StatsMonitor サービスが各リソースの使用率を 1 分間隔でチェックしている

ため、75% 以上が 5 分間(5 count)、 90% 以上が 5 分間(5 count) 継続した

場合に、それぞれアラームがトリガされると解釈できると思います。

Red(重大) に遷移した場合のログを確認すると以下のようになっており、1 分毎

にカウントが増えていっていることが分かります。

2023-06-18T05:56:07.662Z info StatsMonitor[39399] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: cpu.util value: 63.1109 status: green

2023-06-18T05:56:07.662Z info StatsMonitor[39399] [Originator@6876 sub=StatsMonitor] [Unit test] wCount=0 cCount=0

2023-06-18T05:57:07.758Z info StatsMonitor[39399] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: cpu.util value: 99.9989 status: green

2023-06-18T05:57:07.762Z info StatsMonitor[39399] [Originator@6876 sub=StatsMonitor] [Unit test] wCount=1 cCount=1

2023-06-18T05:58:07.903Z info StatsMonitor[39399] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: cpu.util value: 99.9879 status: green

2023-06-18T05:58:07.903Z info StatsMonitor[39399] [Originator@6876 sub=StatsMonitor] [Unit test] wCount=2 cCount=2

2023-06-18T05:59:07.940Z info StatsMonitor[39399] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: cpu.util value: 99.9967 status: green

2023-06-18T05:59:07.940Z info StatsMonitor[39399] [Originator@6876 sub=StatsMonitor] [Unit test] wCount=3 cCount=3

2023-06-18T06:00:08.122Z info StatsMonitor[39399] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: cpu.util value: 100.002 status: green

2023-06-18T06:00:08.122Z info StatsMonitor[39399] [Originator@6876 sub=StatsMonitor] [Unit test] wCount=4 cCount=4

2023-06-18T06:01:08.323Z info StatsMonitor[39399] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: cpu.util value: 99.9981 status: green

2023-06-18T06:01:08.323Z info StatsMonitor[39399] [Originator@6876 sub=StatsMonitor] Raised WARNING alarm: 5 vs. 5.

2023-06-18T06:01:08.323Z info StatsMonitor[39399] [Originator@6876 sub=StatsMonitor] Raised CRITICAL alarm: 5 vs. 5.

2023-06-18T06:01:08.323Z info StatsMonitor[39399] [Originator@6876 sub=StatsMonitor] [Unit test] wCount=5 cCount=5

2023-06-18T06:01:08.323Z info StatsMonitor[39399] [Originator@6876 sub=StatsMonitor] Post event: cpu.util status changed from green to red.

2023-06-18T06:01:08.344Z info StatsMonitor[39397] [Originator@6876 sub=StatsMonitor] eventMessage: [{"event_id": "vim.event.ResourceExhaustionStatusChangedEvent","args":{"resourceName":"cpu_util","oldStatus":"green","newStatus":"red","reason":"for continuous CPU utilization 90% in 727977843 mins"}}]/storage/log

<Log Disk Exhaustion> は、75% で Yellow(警告)、85% で Red(重大)

と言う結果でした。

vCenter Log File System Resource status changed from Green to Yellow on ss098.home.com for continuous Disk utilization 75%

vCenter Log File System Resource status changed from Green to Red on ss098.home.com for continuous Disk utilization 85%ログからは、[warning threshold=75 critical threshold=85] と

なっていることが確認でき、[storage.util.filesystem.log value:]

から使用率が確認できます。

2023-06-18T06:23:24.117Z info StatsMonitor[39398] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: storage.util.filesystem.log value: 94.0195 status: green

2023-06-18T06:23:24.117Z info StatsMonitor[39398] [Originator@6876 sub=StatsMonitor] [Unit test] Alarm check cfg warning threshold=75 critical threshold=85 warning alarm raise count=5 critical alarm raise count=5[warning alarm raise count=5 critical alarm raise count=5] に関しては、

StatsMonitor サービスが各リソースの使用率を 1 分間隔でチェックいるため、

75% 以上が 5 分間(5 count)、 85% 以上が 5 分間(5 count) 継続した場合に、

それぞれアラームがトリガされると解釈できると思います。

Red(重大) に遷移した場合のログを確認すると以下のようになっており、1 分毎

にカウントが増えていっていることが分かります。

2023-06-18T06:21:15.744Z info StatsMonitor[39398] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: storage.util.filesystem.log value: 13.7788 status: green

2023-06-18T06:21:15.744Z info StatsMonitor[39398] [Originator@6876 sub=StatsMonitor] [Unit test] wCount=0 cCount=0

2023-06-18T06:23:24.117Z info StatsMonitor[39398] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: storage.util.filesystem.log value: 94.0195 status: green

2023-06-18T06:23:24.117Z info StatsMonitor[39398] [Originator@6876 sub=StatsMonitor] [Unit test] wCount=1 cCount=1

2023-06-18T06:25:27.173Z info StatsMonitor[39398] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: storage.util.filesystem.log value: 94.0279 status: green

2023-06-18T06:25:27.173Z info StatsMonitor[39398] [Originator@6876 sub=StatsMonitor] [Unit test] wCount=2 cCount=2

2023-06-18T06:27:27.281Z info StatsMonitor[39398] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: storage.util.filesystem.log value: 94.0389 status: green

2023-06-18T06:27:27.281Z info StatsMonitor[39398] [Originator@6876 sub=StatsMonitor] [Unit test] wCount=3 cCount=3

2023-06-18T06:29:27.848Z info StatsMonitor[39398] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: storage.util.filesystem.log value: 94.047 status: green

2023-06-18T06:29:27.848Z info StatsMonitor[39398] [Originator@6876 sub=StatsMonitor] [Unit test] wCount=4 cCount=4

2023-06-18T06:31:29.791Z info StatsMonitor[39398] [Origin2023-06-18T06:31:29.791Z info StatsMonitor[39398] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: storage.util.filesystem.log value: 94.0372 status: green

2023-06-18T06:31:29.791Z info StatsMonitor[39398] [Originator@6876 sub=StatsMonitor] [Unit test] Alarm check cfg warning threshold=75 critical threshold=85 warning alarm raise count=5 critical alarm raise count=5

2023-06-18T06:31:29.791Z info StatsMonitor[39398] [Originator@6876 sub=StatsMonitor] Raised WARNING alarm: 5 vs. 5.

2023-06-18T06:31:29.791Z info StatsMonitor[39398] [Originator@6876 sub=StatsMonitor] Raised CRITICAL alarm: 5 vs. 5.

2023-06-18T06:31:29.791Z info StatsMonitor[39398] [Originator@6876 sub=StatsMonitor] [Unit test] wCount=5 cCount=5

2023-06-18T06:31:29.791Z info StatsMonitor[39398] [Originator@6876 sub=StatsMonitor] Post event: storage.util.filesystem.log status changed from green to red.

2023-06-18T06:31:30.739Z info StatsMonitor[39520] [Originator@6876 sub=StatsMonitor] eventMessage: [{"event_id": "vim.event.ResourceExhaustionStatusChangedEvent","args":{"resourceName":"storage_util_filesystem_log","oldStatus":"green","newStatus":"red","reason":"for continuous Disk utilization 85% in 10 mins"}}]なお、注意点として df -h で確認できるディスク使用率と VAMI から

確認できるディスク使用率は多少の差異があります。

<Log Disk Exhaustion> は、VAMI から確認できるディスク使用率を

元にアラームがトリガされるため、その点は注意が必要です。

以下は VAMI と df -h の値を同じタイミングで取得したものです。

(VAMI の方が、数 % 低いです。)

root@ss106 [ /var/log/vmware/statsmon ]# df -h

Filesystem Size Used Avail Use% Mounted on

devtmpfs 6.9G 0 6.9G 0% /dev

tmpfs 6.9G 1.1M 6.9G 1% /dev/shm

tmpfs 6.9G 1.3M 6.9G 1% /run

tmpfs 6.9G 0 6.9G 0% /sys/fs/cgroup

/dev/mapper/vg_root_0-lv_root_0 47G 11G 35G 23% /

tmpfs 6.9G 5.4M 6.9G 1% /tmp

/dev/sda3 488M 40M 412M 9% /boot

/dev/sda2 10M 2.0M 8.1M 20% /boot/efi

/dev/mapper/core_vg-core 25G 40K 24G 1% /storage/core

/dev/mapper/log_vg-log 9.8G 9.2G 64M 100% /storage/log ★★★

/dev/mapper/db_vg-db 9.8G 99M 9.2G 2% /storage/db

/dev/mapper/dblog_vg-dblog 15G 65M 14G 1% /storage/dblog

/dev/mapper/seat_vg-seat 9.8G 38M 9.2G 1% /storage/seat

/dev/mapper/netdump_vg-netdump 982M 24K 915M 1% /storage/netdump

/dev/mapper/autodeploy_vg-autodeploy 9.8G 40K 9.3G 1% /storage/autodeploy

/dev/mapper/imagebuilder_vg-imagebuilder 9.8G 36K 9.3G 1% /storage/imagebuilder

/dev/mapper/updatemgr_vg-updatemgr 98G 269M 93G 1% /storage/updatemgr

/dev/mapper/archive_vg-archive 49G 138M 47G 1% /storage/archive

/dev/mapper/vtsdb_vg-vtsdb 9.8G 31M 9.2G 1% /storage/vtsdb

/dev/mapper/vtsdblog_vg-vtsdblog 4.9G 17M 4.6G 1% /storage/vtsdblog

/dev/mapper/lifecycle_vg-lifecycle 98G 3.9G 90G 5% /storage/lifecycle

/dev/mapper/vg_lvm_snapshot-lv_lvm_snapshot 147G 28K 140G 1% /storage/lvm_snapshotその他のアラーム

上記で案内していない以下のアラームについては、今回は動作検証を

行いませんでしたがログ上では <Log Disk Exhaustion> と同じ、

75% で Yellow(警告)、85% で Red(重大) に見受けられます。

SEAT Disk Exhaustion on <vCSA のホスト名>

Core and Inventory Disk Exhaustion on <vCSA のホスト名>

Root Disk Exhaustion on <vCSA のホスト名>

Boot Disk Exhaustion on <vCSA のホスト名>

Autodeploy Disk Exhaustion on <vCSA のホスト名>

Diagnostics Disk Exhaustion on <vCSA のホスト名>

Image Builder Disk Exhaustion on <vCSA のホスト名>

ESXi Dump Collector Disk Exhaustion on <vCSA のホスト名>

Update Manager Disk Exhaustion on <vCSA のホスト名>

Lifecycle Disk Exhaustion on <vCSA のホスト名>

LVM Snapshot Disk Exhaustion on <vCSA のホスト名>

vStats DB Disk Exhaustion on <vCSA のホスト名>2023-06-18T23:22:20.265Z info StatsMonitor[02354] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: storage.util.filesystem.seat value: 0.820263 status: green

2023-06-18T23:22:20.348Z info StatsMonitor[02354] [Originator@6876 sub=StatsMonitor] [Unit test] Alarm check cfg warning threshold=75 critical threshold=85 warning alarm raise count=5 critical alarm raise count=5

2023-06-18T23:22:20.351Z info StatsMonitor[02354] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: storage.util.filesystem.db value: 1.45082 status: green

2023-06-18T23:22:20.351Z info StatsMonitor[02354] [Originator@6876 sub=StatsMonitor] [Unit test] Alarm check cfg warning threshold=75 critical threshold=85 warning alarm raise count=5 critical alarm raise count=5

2023-06-18T23:22:20.407Z info StatsMonitor[02354] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: storage.util.filesystem.root value: 15.6206 status: green

2023-06-18T23:22:20.407Z info StatsMonitor[02354] [Originator@6876 sub=StatsMonitor] [Unit test] Alarm check cfg warning threshold=75 critical threshold=85 warning alarm raise count=5 critical alarm raise count=5

2023-06-18T23:22:20.408Z info StatsMonitor[02354] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: storage.util.filesystem.boot value: 6.12742 status: green

2023-06-18T23:22:20.408Z info StatsMonitor[02354] [Originator@6876 sub=StatsMonitor] [Unit test] Alarm check cfg warning threshold=75 critical threshold=85 warning alarm raise count=5 critical alarm raise count=5

2023-06-18T23:22:20.410Z info StatsMonitor[02354] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: storage.util.filesystem.autodeploy value: 0.360129 status: green

2023-06-18T23:22:20.410Z info StatsMonitor[02354] [Originator@6876 sub=StatsMonitor] [Unit test] Alarm check cfg warning threshold=75 critical threshold=85 warning alarm raise count=5 critical alarm raise count=5

2023-06-18T23:22:20.411Z info StatsMonitor[02354] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: storage.util.filesystem.core value: 0.613208 status: green

2023-06-18T23:22:20.411Z info StatsMonitor[02354] [Originator@6876 sub=StatsMonitor] [Unit test] Alarm check cfg warning threshold=75 critical threshold=85 warning alarm raise count=5 critical alarm raise count=5

2023-06-18T23:22:20.412Z info StatsMonitor[02354] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: storage.util.filesystem.imagebuilder value: 0.36009 status: green

2023-06-18T23:22:20.412Z info StatsMonitor[02354] [Originator@6876 sub=StatsMonitor] [Unit test] Alarm check cfg warning threshold=75 critical threshold=85 warning alarm raise count=5 critical alarm raise count=5

2023-06-18T23:22:20.413Z info StatsMonitor[02354] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: storage.util.filesystem.lifecycle value: 4.10168 status: green

2023-06-18T23:22:20.413Z info StatsMonitor[02354] [Originator@6876 sub=StatsMonitor] [Unit test] Alarm check cfg warning threshold=75 critical threshold=85 warning alarm raise count=5 critical alarm raise count=5

2023-06-18T23:22:20.415Z info StatsMonitor[02354] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: storage.util.filesystem.lvm_snapshot value: 0.0399763 status: green

2023-06-18T23:22:20.415Z info StatsMonitor[02354] [Originator@6876 sub=StatsMonitor] [Unit test] Alarm check cfg warning threshold=75 critical threshold=85 warning alarm raise count=5 critical alarm raise count=5

2023-06-18T23:22:20.417Z info StatsMonitor[02354] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: storage.util.filesystem.netdump value: 0.252471 status: green

2023-06-18T23:22:20.417Z info StatsMonitor[02354] [Originator@6876 sub=StatsMonitor] [Unit test] Alarm check cfg warning threshold=75 critical threshold=85 warning alarm raise count=5 critical alarm raise count=5

2023-06-18T23:22:20.418Z info StatsMonitor[02354] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: storage.util.filesystem.updatemgr value: 0.319503 status: green

2023-06-18T23:22:20.418Z info StatsMonitor[02354] [Originator@6876 sub=StatsMonitor] [Unit test] Alarm check cfg warning threshold=75 critical threshold=85 warning alarm raise count=5 critical alarm raise count=5

2023-06-18T23:22:20.419Z info StatsMonitor[02354] [Originator@6876 sub=StatsMonitor] [Unit Check] Alarm Check: storage.util.filesystem.vtsdb value: 0.668459 status: green

2023-06-18T23:22:20.419Z info StatsMonitor[02354] [Originator@6876 sub=StatsMonitor] [Unit test] Alarm check cfg warning threshold=75 critical threshold=85 warning alarm raise count=5 critical alarm raise count=5まとめ

今回は私自身で行った検証結果を記載しており、バージョンの差異等

によっては異なる場合も考えられますので、その点ご注意ください。